L’intelligence artificielle n’a jamais été aussi présente dans les discussions qu’au cours des dernières années ! Son utilité exceptionnelle sera mise en lumière à travers plusieurs exemples dans ce blog, mais elle suscite aussi des inquiétudes et des peurs, alimentées à la fois par la fiction et par une certaine méconnaissance. L’objectif de cet article est de clarifier le fonctionnement de l’intelligence artificielle. Il est essentiel de comprendre son fonctionnement, non seulement pour dissiper les fantasmes qui l’entourent, mais aussi pour savoir l’utiliser de manière efficace.

Au menu :

ToggleDéfinition de l’Intelligence Artificielle

L’intelligence artificielle désigne un ensemble de techniques et de modèles mathématiques permettant à une machine de simuler certaines capacités cognitives humaines, telles que la perception, la compréhension du langage ou la prise de décision. Elle repose sur des algorithmes capables d’analyser des données, d’en extraire des modèles sous-jacents et de s’améliorer grâce à l’expérience.

L’IA ne se limite pas à une seule technologie ou méthode ; elle couvre un large éventail de techniques, allant de l’analyse de données classiques à des systèmes capables d’apprendre de manière autonome.

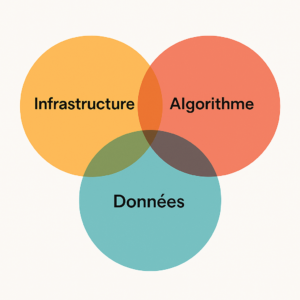

Les piliers de l’Intelligence Artificielle

L’IA repose sur trois piliers fondamentaux :

-

Les données : l’IA a besoin de grandes quantités de données de qualité pour fonctionner efficacement. On parle souvent de la donnée comme étant le « carburant », indispensable au fonctionnement de l’intelligence artificielle. Plus les données sont pertinentes et diversifiées, plus les modèles peuvent générer des résultats précis.

-

Les algorithmes : ils permettent d’analyser les données, d’en apprendre et de prendre des décisions en fonction des informations traitées. Ils sont au cœur de l’IA et peuvent être très simples ou extrêmement complexes.

-

L’infrastructure : elle est indispensable pour entraîner et exécuter les modèles sur des volumes de données parfois très importants. Elle comprend le matériel (GPU, TPU, serveurs) et les frameworks logiciels (TensorFlow, PyTorch) nécessaires.

Les différentes branches

L’intelligence artificielle se divise en plusieurs branches, qui peuvent être regroupées selon les approches qu’elles utilisent. Voici les principales

Symbolique : l‘IA symbolique est restée le modèle dominant de la recherche en IA de ses débuts au milieu des années 1990. Cette approche repose sur des règles explicites et des bases de connaissances. Très utilisée dans les débuts de l’IA, elle se retrouve dans les systèmes experts, la logique floue et les moteurs d’inférence. Exemples : Prolog (langage de programmation logique), ontologies dans le web sémantique. Bien que précise pour des cas spécifiques, elle est limitée face aux problèmes complexes nécessitant des adaptations.

Statistique : cette approche moderne exploite des modèles probabilistes et des algorithmes d’apprentissage automatique pour extraire des tendances à partir de données massives. Le deep learning, basé sur les réseaux de neurones, en est l’exemple le plus avancé. Exemples : Scikit-learn, TensorFlow, PyTorch. Cette approche a prouvé son efficacité dans des domaines comme la vision par ordinateur et le traitement du langage naturel.

Hybridation : cette méthode combine les approches symboliques et statistiques pour obtenir des performances optimales. Par exemple, IBM Watson mélange des règles logiques et des modèles statistiques pour comprendre le langage naturel. Les assistants vocaux comme Siri ou Google Assistant utilisent aussi une hybridation en combinant des bases de connaissances avec du deep learning. Cette approche, déjà utilisée mais toujours en cours d’amélioration, tente de pallier les limitations de chaque méthode pour améliorer la fiabilité des systèmes.

IA faible, IA forte et IA superintelligente

L’intelligence artificielle peut être classée en fonction de ses capacités et de son degré d’autonomie. Ces distinctions permettent de mieux comprendre les types de systèmes d’IA existants et leurs objectifs :

IA Faible (ou étroite)

L’IA faible est spécialisée dans des tâches très précises, souvent dans des domaines limités où elle peut exceller. Ces systèmes ne possèdent pas de conscience ou de compréhension générale. Ils sont programmés pour effectuer une tâche spécifique, comme la reconnaissance d’images, la recommandation de films, ou la gestion des stocks.

C’est ce type d’IA qui est utilisée de nos jours.

Exemples : Siri, les systèmes de recommandation sur Netflix ou Amazon, les assistants vocaux, ChatGPT, …

IA Forte (ou générale)

L’IA forte serait une intelligence capable d’effectuer n’importe quelle tâche cognitive humaine, à la manière d’un être humain. Un tel système serait capable de comprendre des concepts, de raisonner de façon autonome, et de résoudre une large variété de problèmes dans différents domaines. Cette forme d’IA reste pour l’instant théorique et n’a pas encore été réalisée.

Exemples : Les robots humanoïdes capables d’interagir avec des humains de manière naturelle, mais cela relève encore de la science-fiction.

IA Superintelligente

L’IA superintelligente fait référence à une forme d’intelligence qui dépasserait l’intelligence humaine dans tous les domaines : raisonnement, créativité, prise de décision, etc. Bien qu’elle soit un sujet de débat parmi les chercheurs, elle demeure un concept hypothétique. Si un tel système voyait le jour, il pourrait potentiellement avoir un impact radical sur la société et la civilisation humaine.

Types d’IA : Générative, Prédictive, et Autres

Le fonctionnement de l’intelligence artificielle se distingue non seulement par ses techniques, mais aussi par les types de tâches qu’elle accomplit. Voici les principales catégories d’IA en fonction de leur objectif :

IA Générative

L’IA générative est une approche qui permet de créer du contenu, que ce soit du texte, des images, de la musique, ou même des vidéos. Cette forme d’IA utilise des modèles tels que les réseaux de neurones génératifs (GAN) ou les modèles de langage comme GPT-3 pour produire de nouveaux exemples à partir de données existantes.

Exemples : La génération de texte par ChatGPT, la création d’images avec DALL·E, ou la musique générée par des IA comme OpenAI Jukedeck.

IA Prédictive

L’IA prédictive est utilisée pour prévoir des événements futurs en se basant sur des données passées. Elle utilise des algorithmes d’apprentissage supervisé pour identifier des patterns dans les données et faire des prévisions.

Exemples : Les systèmes de recommandations sur des plateformes comme Netflix ou Amazon, la prévision des ventes, la détection de fraudes, ou encore l’analyse des comportements clients.

IA Descriptive

L’IA descriptive est utilisée principalement pour analyser des données existantes afin d’en tirer des insights ou des informations qui peuvent être utiles à la prise de décision. Elle s’intéresse à ce qui s’est déjà passé et sert à fournir une vue d’ensemble ou à résumer des données. Elle permet de comprendre les tendances, les comportements ou les patterns dans un jeu de données.

Les Différents Types d’Apprentissage

L’apprentissage automatique (Machine Learning) est au cœur de l’IA moderne. Il permet aux modèles de s’entraîner sur des données pour accomplir diverses tâches sans intervention humaine directe. Il existe plusieurs types d’apprentissage dans le fonctionnement de l’intelligence artificielle:

Apprentissage supervisé

-

Fonctionnement : L’algorithme apprend à partir d’un jeu de données étiqueté où chaque entrée est associée à une sortie attendue. Il ajuste ses paramètres en minimisant l’erreur entre les prédictions et les réponses attendues.

-

Exemples d’application : Classification d’images, détection de spams, reconnaissance vocale.

Apprentissage non supervisé

-

Fonctionnement : Aucune sortie n’est définie, l’algorithme détecte des structures cachées dans les données (clustering, réduction de dimensionnalité). Il cherche à grouper ou structurer les données selon des similarités statistiques sans indication explicite.

-

Exemples d’application : Segmentation de clients, compression de données, détection d’anomalies. Utile pour explorer des données massives et découvrir des tendances inconnues.

Apprentissage semi-supervisé

-

Fonctionnement : Mélange de l’apprentissage supervisé et non supervisé. Une petite quantité de données étiquetées est utilisée avec une grande quantité de données non étiquetées. L’algorithme généralise mieux en exploitant les relations entre les données connues et inconnues.

-

Exemples d’application : Reconnaissance faciale, analyse de texte, détection de fraudes.

Apprentissage par renforcement

-

Fonctionnement : L’algorithme effectue des actions et reçoit des récompenses (points positifs) ou des pénalités (points négatifs). Ces récompenses sont attribuées par une fonction de récompense définie par l’humain, qui peut être basée sur des critères mesurables comme la réussite d’un objectif ou l’optimisation d’une ressource. Dans certains cas, un simulateur ou un environnement automatisé attribue ces récompenses en fonction des performances de l’agent.

-

Exemples d’application : ChatGPT et d’autres modèles d’IA générative utilisent l’apprentissage par renforcement avec feedback humain (RLHF) pour améliorer la qualité des réponses générées.

Deep learning : la révolution de l’IA moderne

Le deep learning (ou apprentissage profond) est une sous-catégorie de l’apprentissage automatique, inspirée par la structure du cerveau humain, plus précisément par les réseaux de neurones biologiques. Cette approche a radicalement transformé le fonctionnement de l’intelligence artificielle et est à la base des avancées majeures que l’on observe dans des domaines tels que la reconnaissance d’images, le traitement du langage naturel, ou encore la génération de texte.

Qu’est-ce qu’un Réseau de Neurones ?

Un réseau de neurones est composé de multiples couches de neurones artificiels interconnectés, capables de transformer et d’analyser les données à travers plusieurs étapes d’apprentissage. Chaque neurone reçoit un ensemble d’entrées (données) et applique une fonction mathématique pour produire une sortie. Ces réseaux de neurones sont entraînés à l’aide de données massives, et chaque sortie peut être ajustée au fur et à mesure de l’apprentissage, en fonction des erreurs observées.

Le Fonctionnement du Deep Learning

Le deep learning repose sur des réseaux dits « profonds », c’est-à-dire qu’ils comportent de nombreuses couches de neurones. Plus un réseau est profond, plus il peut apprendre des caractéristiques complexes à partir des données.

-

Entraînement : Le réseau de neurones apprend à partir d’un ensemble de données (images, texte, etc.). Lors de l’entraînement, les poids de chaque neurone sont ajustés pour minimiser l’erreur de prédiction, grâce à un algorithme appelé rétropropagation.

-

Rétropropagation : Il s’agit d’un processus qui permet de modifier les poids des connexions entre neurones en fonction de l’erreur générée par la prédiction du modèle. Ce processus est répété de nombreuses fois pour améliorer la précision du modèle.

Applications du Deep Learning

Le deep learning a révolutionné plusieurs secteurs :

-

Reconnaissance d’images : Des systèmes comme Google Vision ou les voitures autonomes utilisent des réseaux de neurones profonds pour identifier et classer des objets dans des images.

-

Traitement du langage naturel : Des modèles comme GPT-3 ou BERT utilisent des réseaux de neurones pour comprendre et générer du texte, offrant des performances exceptionnelles dans des tâches comme la traduction automatique, la génération de texte ou les chatbots.

-

Synthèse vocale et reconnaissance vocale : Des technologies comme Siri ou Alexa reposent sur des modèles de deep learning pour comprendre la parole humaine et répondre de manière pertinente.

Les modèles de langage (LLM)

Les grands modèles de langage (LLM) comme GPT-3 ou BERT sont des systèmes d’IA capables de comprendre et générer du texte en imitant les capacités humaines de traitement du langage. CEtte notion est essentielle dans le fonctionnement de l’intelligence artificielle. Ces modèles reposent principalement sur l’architecture transformer, qui permet une gestion efficace des relations entre mots grâce à des mécanismes d’attention.

Qu’est ce que c’est?

Un LLM apprend à prédire ou générer des séquences de texte en analysant de grandes quantités de données textuelles. Il fonctionne en apprenant des relations entre les mots (ou tokens) dans le texte pour produire des réponses cohérentes.

Les tokens sont des unités de texte que le modèle traite, qui peuvent être des mots complets ou des sous-parties de mots. Par exemple, « incroyable » peut être découpé en « incroy » et « able ». Les tokens permettent au modèle de comprendre et de prédire des séquences de texte.

L’architecture transformer repose sur des mécanismes d’attention, où chaque token peut « se concentrer » sur d’autres tokens dans la séquence pour mieux comprendre le contexte global. Cela permet une meilleure gestion des relations complexes entre les mots.

Les LLM sont entraînés en deux étapes :

-

Pré-entraînement : Le modèle apprend à prédire des mots dans de grandes bases de données textuelles.

-

Fine-tuning : Le modèle est ajusté pour des tâches spécifiques, comme répondre à des questions ou générer du texte, à l’aide de données supplémentaires.

Les LLM sont par exemple utilisés pour :

-

Génération de texte (ex : ChatGPT, génération d’articles),

-

Traduction automatique (ex : Google Translate),

-

Analyse sémantique (ex : recherche d’informations),

-

Chatbots (ex : Siri, Alexa).

Consulting en intelligence artificielle | Formations | Diagnostic IA |Intégration de solutions IA en entreprise

Retrouvez toutes mes offres dans la section : Mes services